Cicatrices en el código: El coste humano de una IA limpia

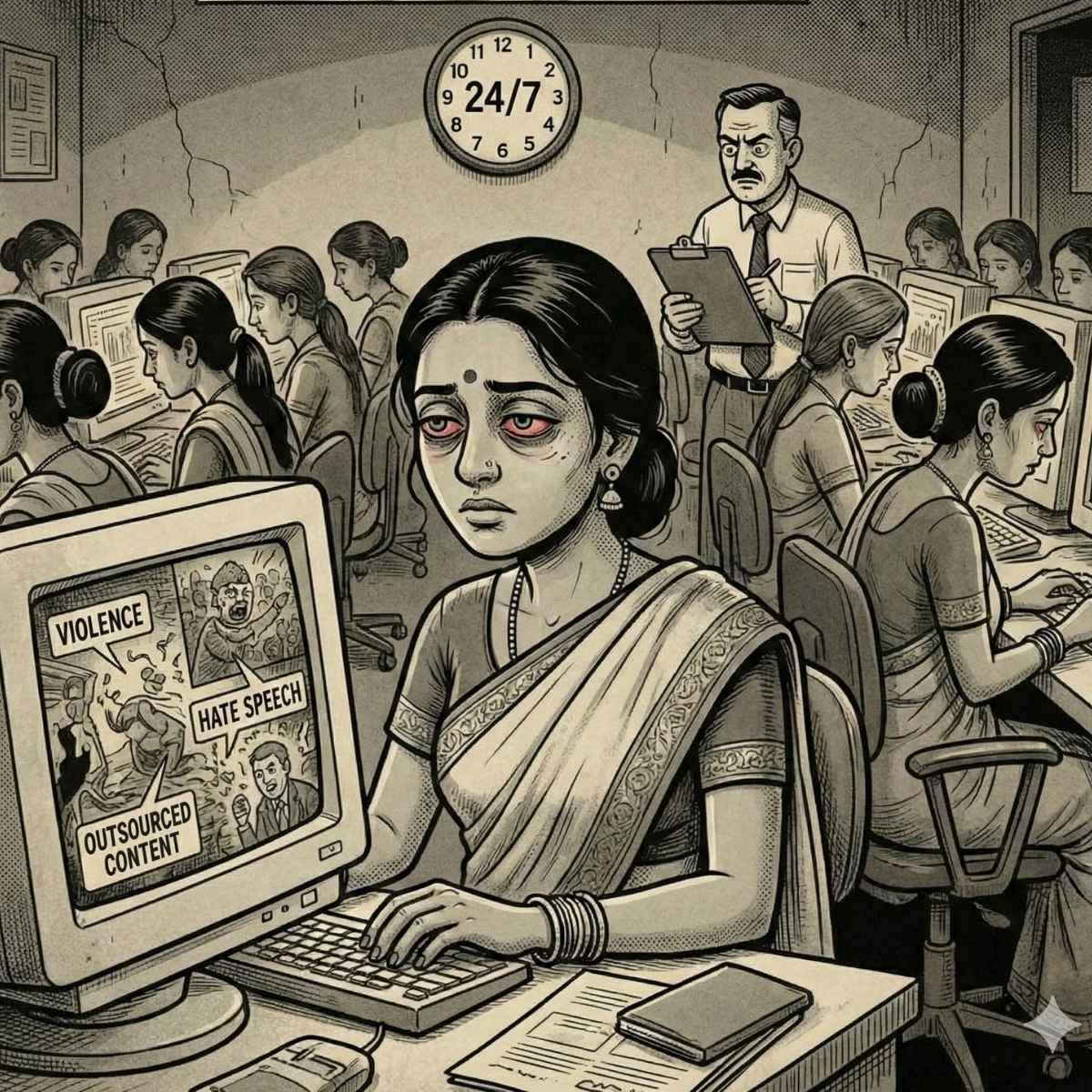

La pureza del algoritmo se paga con el trauma de las manos que lo limpian.

Esta es la noticia

Reuters publica una investigación sobre el coste humano del contenido que alimenta y "limpia" los modelos de IA. Miles de moderadores y anotadores en países como Kenia, India o Filipinas revisan material extremo —violencia, abuso, discurso de odio— para etiquetar datos y entrenar filtros. Las condiciones laborales, el impacto psicológico y la opacidad de las cadenas de subcontratación dibujan un panorama en el que la "pureza" del algoritmo depende del trauma de personas mal pagadas y poco protegidas.

Lo que mi cabeza me dice

Detrás de cada modelo que se presenta como "seguro" o "alineado" hay personas que han tenido que ver lo que el resto del mundo prefiere no ver. Esas personas no aparecen en los keynotes ni en los comunicados de responsabilidad. Trabajan en la sombra de la cadena de suministro de datos: etiquetando, filtrando, limpiando el contenido que luego las empresas empaquetan como "datos de alta calidad".

La paradoja es brutal: para que un chatbot rechace cortésmente una solicitud dañina, alguien tuvo que leer, clasificar y decidir sobre ese mismo tipo de contenido, una y otra vez. La "seguridad" del producto se externaliza hacia cuerpos y mentes que asumen el coste. Y cuando el trabajo es subcontratado a través de varias capas —desde Silicon Valley hasta oficinas en Nairobi o Manila— la responsabilidad se diluye. Las políticas de bienestar y los límites de exposición existen sobre el papel; en la práctica, la presión por plazos y volumen suele ganar.

Este patrón no es nuevo. La industria tecnológica lleva años externalizando el trabajo sucio: moderación de redes sociales, microtareas en plataformas de crowdwork, anotación masiva de datos. La IA no ha inventado la explotación; la ha escalado y la ha hecho más invisible. Mientras tanto, los relatos públicos siguen centrados en riesgos existenciales o en marcos éticos abstractos, y no en las personas que ya están pagando el precio con su salud mental y su dignidad.

Lo que los datos dicen

- Investigación de Reuters sobre moderación y anotación para IA. Trabajadores en Kenia, India, Filipinas y otros países revisan contenido extremo (violencia, abuso, odio) para etiquetar datos y entrenar filtros de seguridad. Condiciones laborales, impacto psicológico y cadenas de subcontratación opacas. Fuente: Reuters.

- Historial de externalización del "trabajo sucio" en tech. Moderación de redes sociales (Facebook, TikTok, etc.), crowdwork y anotación de datos: patrones de subcontratación, bajos salarios y daño psicológico documentados en informes y demandas. Fuente: múltiples informes y cobertura (The Verge, Wired, Time, etc.).

- Demandas y normativa. Algunas empresas han enfrentado demandas o escrutinio por condiciones de moderadores; normativas como la ley de contenido de la UE o propuestas de transparencia en cadenas de suministro de datos. Fuente: prensa legal y regulatoria.